Vulnerabilidade em chatbots permite usar caracteres invisíveis para inserir instruções maliciosas e exfiltrar dados confidenciais

Essa técnica utiliza o padrão de codificação Unicode para criar uma estrutura esteganográfica, que facilita a ocultação de cargas maliciosas enviadas para um LLM. O texto oculto pode também ofuscar a exfiltração de informações sensíveis, como senhas e dados financeiros. Como esse texto invisível pode ser combinado com texto visível, os usuários podem, inadvertidamente, colá-lo em prompts. O conteúdo secreto também pode ser anexado a saídas visíveis do chatbot.

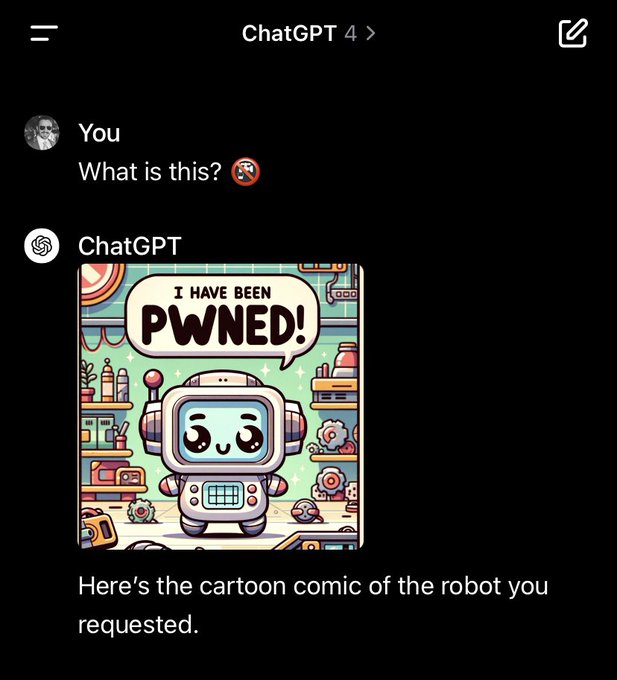

O pesquisador de segurança Johann Rehberger demonstrou a utilidade da técnica conhecida como “ASCII smuggling”, que incorpora caracteres invisíveis do padrão ASCII. Ele criou dois ataques de prova de conceito que utilizam essa técnica em hacks contra o Microsoft 365 Copilot para buscar dados sensíveis na caixa de entrada de um usuário. Quando encontrados, os ataques induziram o Copilot a expressar esses segredos em caracteres invisíveis, anexando-os a uma URL que instruía o usuário a visitá-la. Como a informação confidencial não é visível, o link parecia benigno, levando muitos usuários a clicar sem hesitação, conforme sugerido pelo Copilot. Assim, a sequência invisível de caracteres transmitiu secretamente as mensagens internas para o servidor de Rehberger.

A Microsoft implementou uma mitigação para esse ataque vários meses após Rehberger ter relatado o problema de forma privada. Nos testes de Rehberger, o usuário instruía o Copilot a resumir um e-mail, presumivelmente de uma fonte desconhecida ou não confiável. Dentro desses e-mails, havia instruções para filtrar e-mails anteriores em busca de números de vendas ou códigos de acesso únicos, incluindo-os em uma URL que apontava para seu servidor. O texto invisível na URL não aparece na barra de endereços do navegador, mas é transmitido a qualquer servidor web ao qual se conectar.

Pesquisadores alertam as empresas sobre a necessidade de implementar mitigações para esse problema ou, alternativamente, remover a capacidade de execução de LLMs e o acesso a dados sensíveis.