Como o Sora Realmente Funciona?

Por Gabriel M.

A OpenAI lançou o Sora, que cria vídeos curtos a partir de prompts de texto.

Mas peraí, como é que essa parada funciona mesmo?

Como o Sora funciona?

O Sora é uma mistura de ferramentas de geração de texto e imagem, num esquema chamado “modelo de transformador de difusão”. Os transformadores são um tipo de rede neural que o Google lançou em 2017. Eles são famosos por serem usados em modelos de linguagem gigantes, tipo o ChatGPT e o Google Gemini.

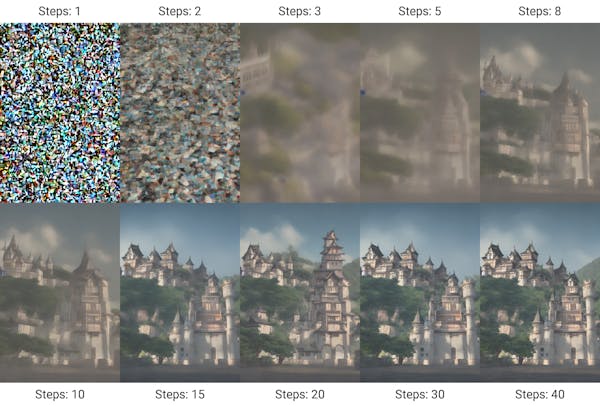

Agora, os modelos de difusão são a base de muitos geradores de imagens de IA. Eles começam com um ruído aleatório e vão iterando até chegar numa imagem “limpa” que se encaixa no prompt de entrada.

Um vídeo pode ser feito a partir de uma sequência dessas imagens. Mas num vídeo, a coerência e a consistência entre os frames são essenciais. O Sora usa a arquitetura do transformador pra lidar com a forma como os frames se relacionam entre si. Embora os transformadores tenham sido inicialmente projetados pra encontrar padrões em tokens que representam texto, o Sora usa tokens que representam pequenos patches filmes.

Hãm? Patches?

Patches, Tokens e Dados

Os patches são uma unidade básica do Sora da mesma forma que o “token” é a unidade básica do GPT. Tokens são pedaços de palavras, enquanto patches são pedaços de filmes.

O GPT-4 foi treinado pra receber uma sequência de tokens e gerar o próximo token na sequência. O Sora foi treinado pra fazer a mesma coisa: ele pega uma sequência de patches e gera o próximo “patch” na sequência.

As abordagens anteriores de texto pra vídeo exigiam que as imagens e os vídeos usados no treinamento tivessem todos o mesmo tamanho, o que exigia um pré-processamento significativo pra reduzir o tamanho dos vídeos. Mas como o Sora treina em “patches” em vez de no quadro completo do vídeo, ele pode engolir qualquer vídeo ou imagem sem precisar cortá-lo.

Daqui pra frente

O GPT-4 parece aprender as regras gramaticais pra prever a próxima palavra numa sequência. Modelos de transformadores de difusão como o Sora parecem aprender física - a gramática do universo - pra prever o próximo segmento de vídeo.

A OpenAI vê o Sora como o primeiro passo num “simulador de mundo” que pode modelar qualquer fatia da realidade com um prompt de texto.

Fiquem ligados que essa parada vai longe!