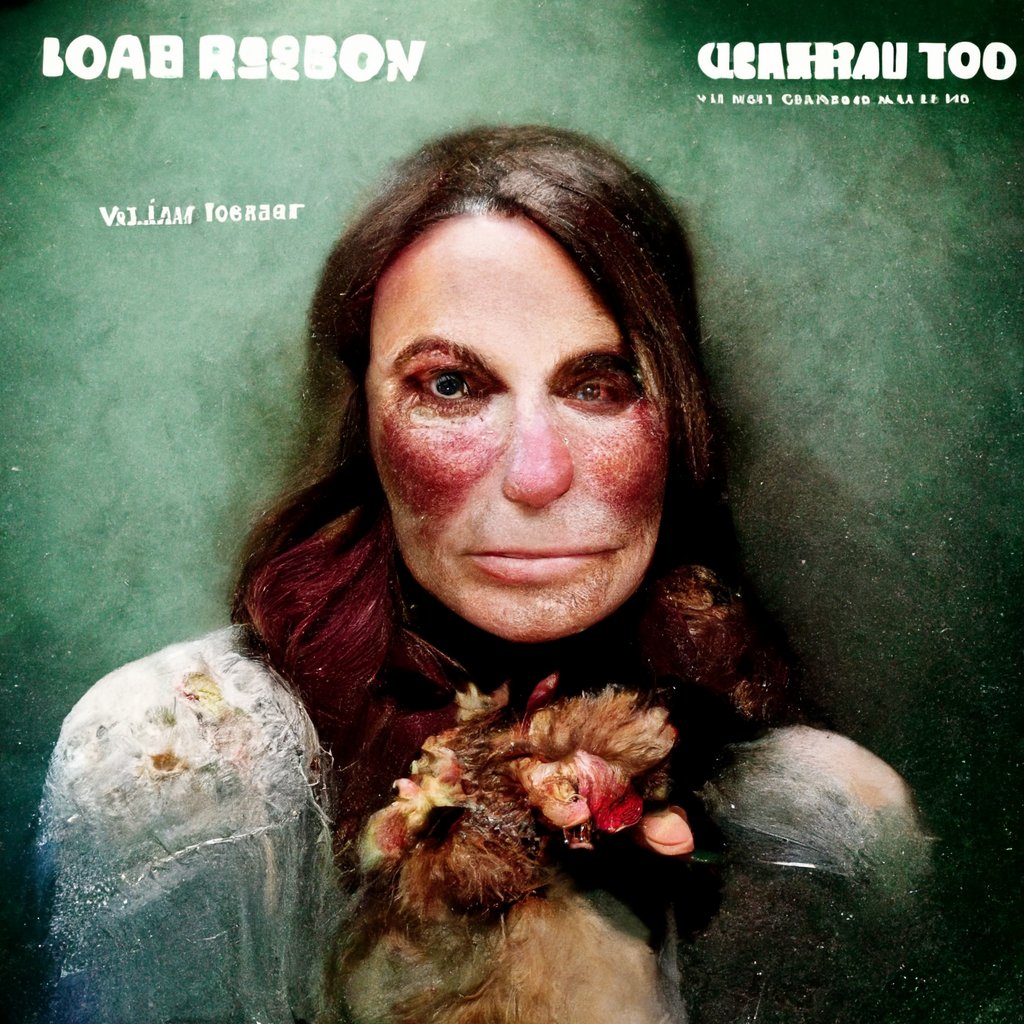

A mulher assustadora que insiste em aparecer em imagens geradas por IA

Sistemas como DALL-E e Midjourney têm ganhado tanta popularidade que já estão se tornando tema de lendas urbanas e creepypastas.

Esse é o caso da Loab, uma mulher aterrorizante que insiste em aparecer nesses geradores de imagens por IA, levando a todo tipo de especulação sobre o que poderia estar causando tal fenômeno inquietante.

Não importa quantas variações são feitas, os resultados insistem em mostrar o rosto da mesma mulher - quase sempre acompanhado por composições grotescas e perturbadoras.

A história foi divulgada inicialmente por um artista de IA chamado Supercomposite e logo viralizou.

Segundo o artista, a Loab foi descoberta pela primeira vez como resultado de uma técnica chamada "pesos negativos de prompt", na qual um usuário tenta fazer com que o sistema de IA gere o oposto do que foi solicitado.

Nesses programas, diferentes termos podem ter diferentes pesos que determinam a probabilidade de eles aparecerem nos resultados. Ao atribuir um peso negativo a uma palavra, você basicamente diz ao sistema de IA: “gere o que você acha que é o oposto dessa palavra”.

Neste caso, o uso de um prompt de peso negativo na palavra “Brando” gerou a imagem de um logotipo com as palavras “DIGITA PNTICS”. Quando o Supercomposite usou a técnica dos pesos negativos nas palavras do logotipo, o resultado foi uma imagem da Loab.

Devido à complexidade desses sistemas, é praticamente impossível saber exatamente por qual motivo isso acontece.

Especialistas em IA já alertaram sobre esse tipo de risco e como a imprevisibilidade dificulta o controle de resultados nocivos.

Embora a OpenAI tenha implementado alguns controles manuais para o DALL-E que bloqueiam e filtram certos termos – para evitar a geração de imagens falsas de celebridades, por exemplo – outros modelos de IA, como Stable Diffusion, podem simplesmente ser hospedados de forma independente. O que leva entusiastas a criarem sua própria instância do software e usá-lo para gerar qualquer tipo de conteúdo que os criadores poderiam se opor.